آبل تدافع عن نهجها لمنع إساءة معاملة الأطفال

حاولت شركة آبل من خلال صفحة أسئلة شائعة جديدة تهدئة المخاوف من أن إجراءاتها الجديدة لمكافحة إساءة معاملة الأطفال يمكن أن تتحول إلى أدوات مراقبة من قبل الحكومات الاستبدادية.

وكتبت الشركة: تقتصر هذه التكنولوجيا على اكتشاف مواد الاعتداء الجنسي على الأطفال CSAM المخزنة في آيكلاود. ولن نوافق على أي طلب حكومي لتوسيعها.

وتشتمل أدوات الشركة الجديدة على ميزتين مصممتين لحماية الأطفال:

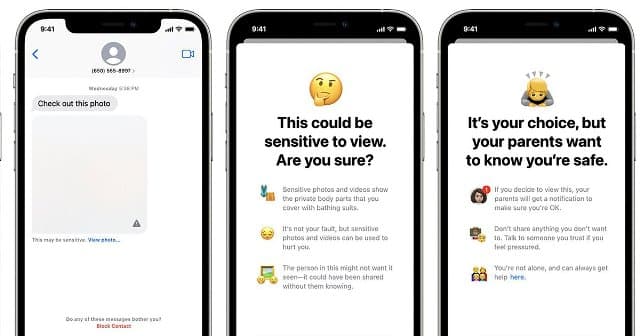

- الأولى: وهي ميزة أمان الاتصال التي تستخدم التعلم الآلي عبر الجهاز لتحديد وتمويه الصور الجنسية الصريحة التي يتلقاها الأطفال في تطبيق الرسائل. ويمكنها إخطار أحد الوالدين إذا قرر طفل يبلغ من العمر 12 عامًا أو أصغر عرض هذه الصورة أو إرسالها.

- الثانية: وهي ميزة مصمم لاكتشاف مواد الاعتداء الجنسي على الأطفال عن طريق مسح صور المستخدمين إذا اختاروا تحميلها عبر آيكلاود. ويتم إخطار الشركة إذا تم اكتشاف مواد الاعتداء الجنسي على الأطفال. التي بدورها تنبه السلطات عندما تتحقق من وجود هذه المواد.

وقوبلت الخطط برد فعل عنيف سريع من مجموعات الخصوصية الرقمية والناشطين. الذين جادلوا بأن هذه توفر بابًا خلفيًا في برامج الشركة.

وتشير هذه المجموعات إلى أنه بمجرد وجود مثل هذا الباب الخلفي، يكون هناك دائمًا احتمال توسيعه للبحث عن أنواع المحتوى التي تتجاوز مواد الاعتداء الجنسي على الأطفال.

ويمكن للحكومات الاستبدادية استخدامه للبحث عن مواد معارضة سياسيًا. و كتبت مؤسسة الحدود الإلكترونية: حتى الباب الخلفي الموثق بدقة والمدروس بعناية والضيق النطاق لا يزال بابًا خلفيًا.

وأضافت: تم إعادة توظيف إحدى التقنيات التي تم إنشاؤها في الأصل لفحص صور الاعتداء الجنسي على الأطفال وتجزئتها لإنشاء قاعدة بيانات للمحتوى الإرهابي الذي يمكن للشركات المساهمة فيه والوصول إليه لغرض حظر مثل هذا المحتوى.

ومع ذلك، تجادل الشركة المصنعة لهواتف آيفون بأن لديها ضمانات لمنع استخدام أنظمتها لاكتشاف أي شيء آخر غير صور الاعتداء الجنسي.

اقرأ أيضًا: ما هي منتجات آبل المتوقعة لهذا العام

آبل تدافع عن نهجها لمنع إساءة معاملة الأطفال

تقول إن قائمة الصور المحظورة مقدمة من المركز الوطني للأطفال المفقودين والمستغلين NCMEC ومنظمات سلامة الأطفال الأخرى. ولا يعمل النظام إلا مع تجزئات صور CSAM المقدمة من NCMEC وغيرها من منظمات سلامة الأطفال.

وأوضحت أنها لن تضيف إلى قائمة تجزئات الصور هذه. وأن القائمة هي نفسها عبر جميع أجهزة آيفون وآيباد لمنع الاستهداف الفردي للمستخدمين.

وأشارت الشركة إلى أنها ترفض مطالب الحكومات بإضافة صور غير CSAM إلى القائمة. وقالت: واجهنا مطالب لبناء التغييرات التي فرضتها الحكومة والتي تقوض خصوصية المستخدمين من قبل، ورفضنا هذه المطالب بثبات. ونستمر في رفضها في المستقبل.

ومن الجدير بالذكر أنه بالرغم من تأكيدات شركة آبل، فقد قدمت تنازلات للحكومات في الماضي من أجل مواصلة العمل في بلدانهم.

وتبيع أجهزة آيفون دون فيس تايم في البلدان التي لا تسمح بالمكالمات الهاتفية المشفرة. وأزالت في الصين آلاف التطبيقات من متجرها للتطبيقات. كما نقلت بيانات المستخدم إلى خوادم اتصالات تديرها الدولة.

وفشلت الشركة في معالجة بعض المخاوف بشأن الميزة التي تقوم بمسح الرسائل بحثًا عن مواد جنسية صريحة.

وتقول إن الميزة لا تشارك أي معلومات مع آبل أو جهات تطبيق القانون. ولكن لا توضح كيف تضمن أن يظل تركيز الأداة على الصور الجنسية الصريحة فقط.

وكتبت مؤسسة الحدود الإلكترونية: كل ما يتطلبه الأمر لتوسيع الباب الخلفي الضيق هو توسيع بارامترات التعلم الآلي للبحث عن أنواع إضافية من المحتوى، أو تعديل علامات الإعداد لمسح حسابات أي شخص، وليس الأطفال فقط.

اقرأ أيضًا: خطة آبل لسلامة الأطفال تواجه انتقادات عديدة